Pesquisadores do Instituto de Tecnologia de Massachusetts (MIT) criaram um programa de inteligência artificial que pode reconhecer os caracteres manuscritos empate depois de ver-lhes um punhado de vezes.

Esta AI pode concluir esta tarefa, bem como as pessoas fazem e ninguém poderia dizer a diferença.

Aprendizado profundo teve muitos avanços, como a fala e reconhecimento facial; no entanto, os programas exigem 100s se não 1,000s de exemplos antes que eles possam descobrir com certeza o que e quem está olhando.

No entanto, o cérebro de um humano vai quebrar o objeto visto em componentes e é aí que o "fosso entre mente aprendizado de máquina e aprendizado humano" continua a ser grande, mas não insuperável.

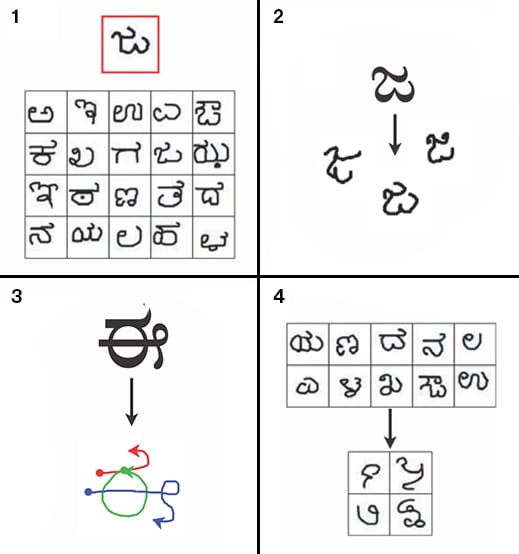

O novo algoritmo de aprendizagem MIT é capaz de imitar humano informação reunindo mais rápido do que é antecessores. A fim de alcançar este objetivo, a equipe usou caracteres manuscritos, porque eles "são bem adequados para comparar humano e aprendizagem de máquina em uma base relativamente uniforme:. Ambos são cognitivamente natural e muitas vezes usado como um ponto de referência para comparar os algoritmos de aprendizagem"

Chamado de aprendizagem programa Bayesian (BPL), o programa é projetado para construir conceitos de imagens em que vai. Para testá-lo, os pesquisadores usaram 1.623 exemplos da escrita humana de línguas em todo o mundo.

Os seres humanos são capazes de reconhecer caracteres com uma taxa média de erro de 4,5%, mas BPL tem uma taxa de erro de 3,3%.Quando a máquina escrito palavras foram dadas para os seres humanos para avaliar, eles não poderiam dizer que foram escritas por BPL e quais eram autenticamente humano.

Isto significa que BPL passou no teste de viragem.

Em 1950, Alan Turing escreveu um artigo intitulado Computing Machinery and Intelligence que fez a pergunta: "As máquinas podem pensar"

O teste de Turing estabelece um "teste para a inteligência em um computador, exigindo que um ser humano deve ser incapaz de distinguir a máquina de outro ser humano, utilizando as respostas às questões colocadas a ambos."

O financiamento para este experimento foi fornecido pelo escritório da força aérea da investigação científica, o Escritório de Pesquisa Naval, o Instituto Army Research, a Agência de Projetos de Pesquisa Avançada de Defesa (DARPA), a Agência de Pesquisa Avançada de Inteligência (IARPA) ea National Science Foundation ( NSF); bem como algumas empresas do setor privado.

Jason Tenenbaum, membro da equipe do MIT, explicou em um comunicado à imprensa: "Pela primeira vez, nós pensamos que temos um sistema de máquina que pode aprender uma grande classe de conceitos visuais de maneiras que são difíceis de distinguir de alunos humanos."

Tenenbaum continuou: "Você mostra até mesmo uma criança um cavalo ou um ônibus escolar ou um skate, e eles obtê-lo a partir de um exemplo. Se você esquecer o que é como ser uma criança, pensar sobre a primeira vez que você viu, digamos, um Segway, um desses dispositivos de transporte pessoais, ou de um smartphone ou um laptop. Você só precisava ver um exemplo e você poderia, então, reconhecer essas coisas de diferentes ângulos, sob diferentes condições de iluminação, muitas vezes pouco visível em cenas complexas com muitos outros objetos. "

FONTES:

0 comentários:

Postar um comentário

Faça seu comentário aqui ou deixe sua opinião.

Observação: somente um membro deste blog pode postar um comentário.